Le 23 novembre 2024 a eu lieu la Journée de l’intelligence artificielle organisée par l’UNIL et l’EPFL. L’occasion de parcourir ses bénéfices et ses risques dans trois disciplines qui l’utilisent : les sciences biomédicales, glaciologiques et criminelles.

L’IA dans les sciences médicales

« J’utilise des intelligences artificielles* depuis longtemps », explique Raphaël Gottardo, professeur de science des données biomédicales à l’UNIL et directeur du Centre de la science des données biomédicales au CHUV. Dans son domaine, « l’IA a énormément progressé, car d’un côté les algorithmes ont été améliorés, et de l’autre on a aussi beaucoup plus de données qui peuvent être traitées, donc beaucoup plus d’apprentissage qui peut être fait ». En médecine, les IA peuvent être mises à profit de différentes façons, de l’allégement des tâches administratives à l’amélioration du soin. Un domaine dans lequel les IA sont particulièrement performantes est l’analyse d’images, en raison de leur grande quantité issue des différentes technologies telles que les IRM, les scanners ou les images colorées de tissus, explique le professeur : « Beaucoup de diagnostics du cancer se font sur l’analyse d’images, c’est-à-dire qu’un pathologiste regarde une image d’une biopsie, puis en fonction de la morphologie des cellules va pouvoir dire si elles sont cancéreuses. Grâce à une méthode nommée « apprentissage supervisé », une machine peut lier ces images à l’étiquette « cancer » ou non posée par des professionnels. » Après l’apprentissage, les IA deviennent très performantes pour reconnaître une tumeur. « Ça peut faire économiser du temps au pathologiste et peut même pousser les diagnostics un petit peu plus loin, c’est-à-dire qu’on va pouvoir voir si la tumeur est agressive ou non, ou si un traitement différent serait nécessaire, et c’est vraiment tout de l’apprentissage automatique*. »

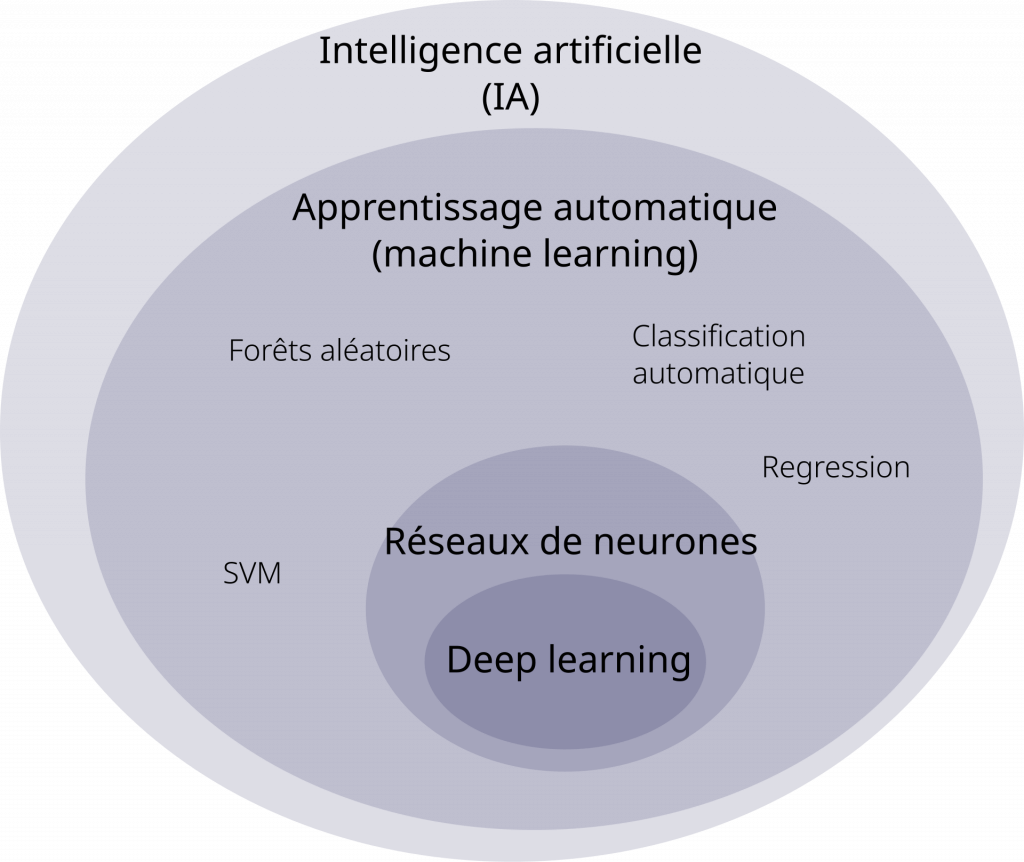

* Quelques définitions…

- Intelligence artificielle (IA) : ensemble de théories et de techniques ayant pour but de simuler l’intelligence humaine.

- Apprentissage automatique (machine learning) : champ d’étude de l’IA qui se fonde sur des approches mathématiques et statistiques pour donner aux ordinateurs la capacité d’apprendre à partir de données.

- Apprentissage profond (deep learning) : sous-domaine de l’apprentissage automatique qui utilise des réseaux de neurones ayant de nombreuses couches pour résoudre des tâches complexes de manière automatique.

C’est justement cet apprentissage automatique qui maximise la puissance des IA. Sans guider exactement les technologies vers une caractéristique précise, celles-ci apprennent par elles-mêmes ce qui différencie une cellule cancéreuse d’une autre. « Les algorithmes d’apprentissage profond* ont ce qu’on réfère souvent à des boîtes noires, c’est-à-dire qu’ils vont faire de bonnes prédictions, on ne sait pas trop comment. » Tout un champ de la recherche en IA s’est alors développé pour essayer d’ouvrir cette boîte noire, appelé Explainable AI : « Je pense qu’on ne va pas pouvoir seulement faire de la prédiction puis fermer les yeux sans se poser de questions. Surtout pour les décisions qui vont être complexes, il va falloir qu’on comprenne comment ça marche. »

En médecine, un gros défi de l’utilisation de l’IA est l’accès aux données pour l’entraînement, continue-t-il : « Si on pouvait mettre toutes les données du monde ensemble, on en aurait énormément, mais ce n’est pas possible parce qu’il y a des limites de confidentialité, de sécurité et d’éthique. » Mais même avec davantage de données et des algorithmes plus performants, la validation humaine restera toujours nécessaire pour le chercheur : « Les machines ne vont jamais prendre de décisions toutes seules, c’est une aide à la décision. Elles permettent de mettre la puce à l’oreille aux cliniciens, aux chercheurs ou aux techniciens pour se focaliser là où il y a peut-être quelque chose qui serait important. Dans 50 ans je pense qu’il y aura toujours une sorte de validation humaine. »

Lorsque l’uniscope lui demande s’il a peur de la puissance des IA et de ce qu’elles pourraient éventuellement devenir, il répond : « Non, vraiment pas. On pourra toujours débrancher l’ordinateur. Je pense qu’il y a d’autres choses qui font plus peur que l’IA, comme l’état du climat. »

L’IA dans les sciences glaciologiques

Et c’est justement le domaine de Guillaume Jouvet, professeur à l’Institut des dynamiques de la surface terrestre. Il utilise des intelligences artificielles afin de modéliser l’évolution des glaciers. « On essaie de reproduire la dernière glaciation dans les Alpes. Il y a aussi des membres de mon groupe qui travaillent sur les prévisions de retrait glaciaire pour le siècle à venir. » L’IA a complètement boosté ses calculs depuis quelques années, et cela grâce à deux facteurs. Premièrement, la rapidité : « L’IA permet d’accélérer nos modèles par plusieurs ordres de magnitude. On arrive à faire aujourd’hui des choses 100, 1000 fois plus vite que ce qu’on faisait il y a vraiment peu de temps. De manière très résumée, l’idée est qu’au lieu de résoudre nos modèles on apprend à les résoudre computationnellement grâce aux IA. » Deuxièmement, l’assimilation des données, dont la quantité augmente de façon exponentielle : « On a énormément de données qu’on obtient par satellite. Le défi est de modéliser les glaciers à travers des équations de la physique fidèlement aux observations. L’IA nous permet de tout mettre en symbiose », explique-t-il.

Pour le chercheur, malgré ces évolutions, il n’y a rien de fondamentalement nouveau : « Nous faisons les mêmes choses différemment et beaucoup plus rapidement, ce qui ouvre de nouvelles perspectives. Mais quand on fait une simple régression linéaire (une méthode statistique couramment utilisée en recherche, ndlr), on fait déjà de l’apprentissage d’une certaine manière. Les réseaux de neurones ont juste bien plus de paramètres (de l’ordre du million) tandis qu’une régression n’en a que deux. »

« L’IA peut nous aider à mieux connaître et anticiper les évolutions des systèmes atmosphériques et cryosphériques. »

Guillaume Jouvet, professeur à l’Institut des dynamiques de la surface terrestre à l’UNIL

Pour lui, le risque dans son domaine réside dans une utilisation non maîtrisée des IA : « Il y a maintenant beaucoup d’outils d’IA qui existent. Étonnamment, on peut avoir des résultats très rapidement. Je me suis fait avoir deux, trois fois, en croyant que ça marchait trop bien. C’est pour cela qu’il est important de bien comprendre l’outil. Le risque est d’être trompeur vis-à-vis de la communauté. » Mais les potentielles erreurs commises ne seront pas grandes, avec suffisamment de recul critique, précise-t-il : « Le processus itératif entre les coauteurs et les référés permet de limiter les risques. »

Face aux défis du réchauffement climatique, l’intelligence artificielle peut devenir une alliée : « Ce qui est sûr, c’est qu’on va faire des progrès significatifs de prévision et de compréhension des systèmes atmosphériques et des systèmes cryosphériques (liés au froid, ndlr). Mieux les connaître et anticiper leurs évolutions peut nous aider à mener les actions nécessaires et à faire en sorte qu’on traite la planète un peu mieux. »

À lui non plus l’IA ne fait pas peur : « Je pense que personne ne peut être indifférent à ça, il y a beaucoup d’inconnues. Mais j’y vois beaucoup de choses excitantes pour la recherche. »

L’IA dans les sciences criminelles

En sciences criminelles, l’excitation liée à l’utilisation des IA peut aussi être de la partie. Elles peuvent réouvrir des cold cases scellés jusque-là, analyser de manière plus performante des traces numériques liées à un crime, identifier des anomalies pour pister des comportements de pédopornographie ou prédire l’occurrence d’un crime. Ce dernier cas est le domaine de Manon Jendly, professeure à l’École des sciences criminelles. Elle a remarqué que le système pénal avait changé d’approche ces dernières années : « Traditionnellement, l’État était focalisé sur la résolution des crimes et la punition de leurs auteurs. Puis dès les années 1990, ce qui coïncide d’ailleurs avec l’avènement du World Wide Web, il a eu cette ambition de détecter précocement les risques criminels et d’intervenir avant même leur occurrence. » Différentes IA ont été développées dans cette optique, notamment dans les domaines de la reconnaissance faciale ou de la prédiction de risques de commission d’infraction.

En Suisse, il n’existe pas d’évaluation automatisée des risques criminels liés aux personnes, mais il y a déjà le recours en Argovie ou à Zurich à des systèmes de « police prédictive », c’est-à-dire à l’utilisation de données recueillies par la police au moment des interventions pour tenter de prédire l’occurrence de cambriolages, les moments et les endroits où ils ont lieu. « Mais on a très vite réalisé que ça ne donnait pas les effets escomptés, qu’il n’y avait pas de diminution des cambriolages imputable au dispositif, précise la chercheuse. En fait, ça mesure juste l’activité policière, donc ça prédit où les patrouilles sont susceptibles de se rendre. » Au-delà de son inefficacité, cette utilisation de l’IA peut s’avérer dangereuse, continue-t-elle : « Utiliser des données passées pour tenter d’anticiper le futur a de gros enjeux. » Aux États-Unis notamment, ces modèles ont sensiblement augmenté le nombre de personnes afrodescendantes et latino-américaines mises en prison : « Les données exploitées ne sont pas toujours représentatives de tous les actes et de tous les auteurs, mais uniquement de ceux auxquels on porte une attention particulière. Comme certains actes sont plus visibles ou visibilisés que d’autres et que certains quartiers, comme certaines personnes, sont surpolicés, les dispositifs nourris de ces données ne font que perpétuer des traitements différentiels. »

« J’aimerais pouvoir croire que nous sommes en mesure d’avoir une conversation démocratique et participative sur le sujet. »

Manon Jendly, professeure à l’École des sciences criminelles à l’UNIL

Pour Manon Jendly, il est nécessaire de remonter aux entreprises qui développent ces IA et qui restent généralement privées : « Quand on n’a pas accès au code parce qu’il est protégé par le secret commercial, la question est de savoir comment procède au juste le système et si la logique lucrative a préséance sur celle de prévenir le crime. Ces entreprises nous vendent aussi l’assurance de plus de sécurité, voire de « plus de bien commun ». Mais qui définit le bien commun ? Qu’est-ce que la sécurité ? » Pour ces raisons, la chercheuse perçoit les IA dans le système pénal comme des « technologies de pouvoir » dont il faudrait fixer le développement et l’utilisation ensemble : « J’aimerais pouvoir croire que nous sommes en mesure d’avoir une conversation démocratique et participative sur le sujet. Il faut impérativement qu’on dialogue plus souvent. Et ce dialogue doit inclure celles et ceux issus des sciences sociales et humaines, celles et ceux issus des sciences computationnelles, mais aussi la population dans son ensemble. Cette dernière est peu souvent sollicitée sur des choix qui ne sont pas seulement technologiques mais aussi de société. »

En conclusion, Manon Jendly dit ne pas avoir peur des IA mais appelle à la vigilance dans leur utilisation : « Il faut se poser la question : en quoi peuvent-elles rendre le monde meilleur ? Après, le font-elles pour tous et toutes ? »

Envie d’en savoir plus sur le fonctionnement, les bénéfices, les limites et les risques des intelligences artificielles ?

Rejoignez Manon Jendly, Guillaume Jouvet, Raphaël Gottardo ainsi que de nombreux·ses autres expert·e·s lors de la Journée de l’intelligence artificielle.

Quoi ? Des ateliers, des conférences, des projections, des expositions et des cafés scientifiques.

Pour qui ? Toute la famille ! Il y aura des ateliers 10-12 ans, 13-15 ans, ainsi que pour les adultes.

Quand ? Le 23 novembre 2024 entre 10h et 17h.

Où ? Au Rolex Learning Center, sur le campus de l’EPFL.

Combien ça coûte ? L’événement est gratuit, mais l’inscription est nécessaire.

Informations et réservations sur le site de l’événement.

Images bannières : Tatiana, Nico Grütter et Stefan Schweihofer / Pixabay