Jean-François (Jeff) Van de Poël – Projet de recherche en cours, partage état juin 2025

This work is licensed under CC BY-NC-SA 4.0

L’IA peut être un outil d’accompagnement qui présente un certain potentiel, mais son utilisation sans cadre peut aussi engendrer des effets pervers sur la cognition et la pédagogie. Nous abordons ci-dessous trois enjeux clés : l’illusion de maîtrise, le rôle de l’IA comme tuteur pédagogique, et l’impact sur la production académique (devoirs, travaux) entre assistance légitime et substitution problématique.

Illusion de maîtrise et nécessité de la pensée critique

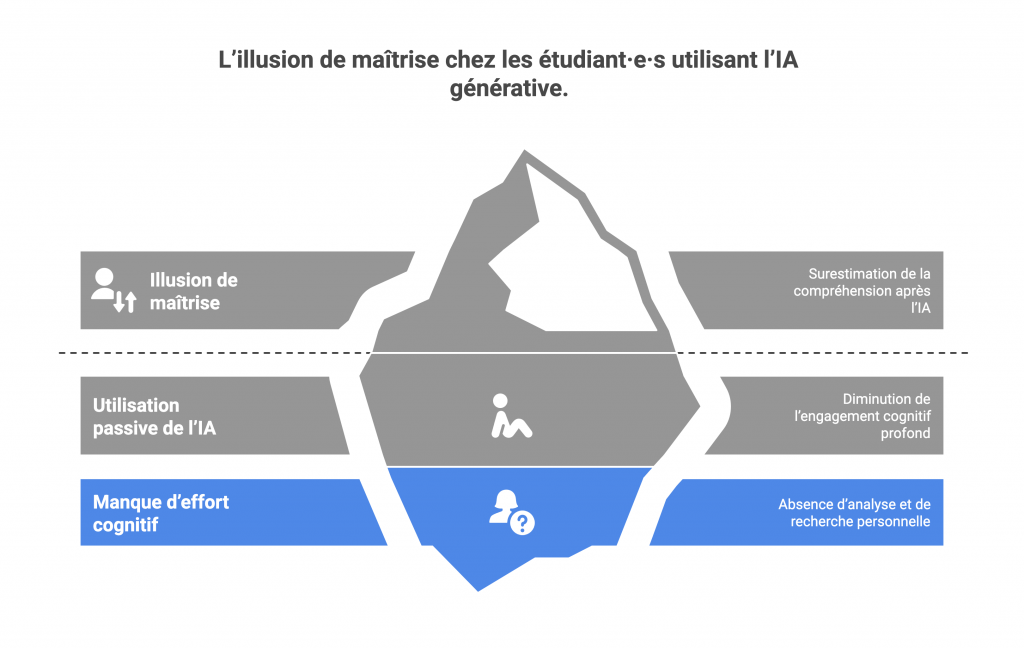

L’un des premiers écueils constatés est le risque d’illusion de maîtrise chez les étudiant·e·s utilisant une IA générative. Ce phénomène, parfois appelé “feeling of knowing”, désigne la tendance à surestimer sa compréhension après avoir obtenu facilement une réponse bien formulée de l’IA.

En effet, face à une explication fluide et cohérente fournie par ChatGPT, un·e étudiant·e peut avoir le sentiment qu’il/elle sait et a compris le concept, alors qu’en réalité il/elle n’a pas mobilisé l’effort cognitif nécessaire pour s’approprier réellement la notion. L’IA peut ainsi renforcer un faux sentiment de compétence : l’apprenant·e croit maîtriser le sujet parce qu’il dispose d’une réponse immédiate, sans avoir eu à analyser ni chercher par lui-même.

Concrètement, cette utilisation passive de l’IA risque de diminuer l’engagement dans des processus cognitifs profonds pourtant essentiels pour un apprentissage durable.

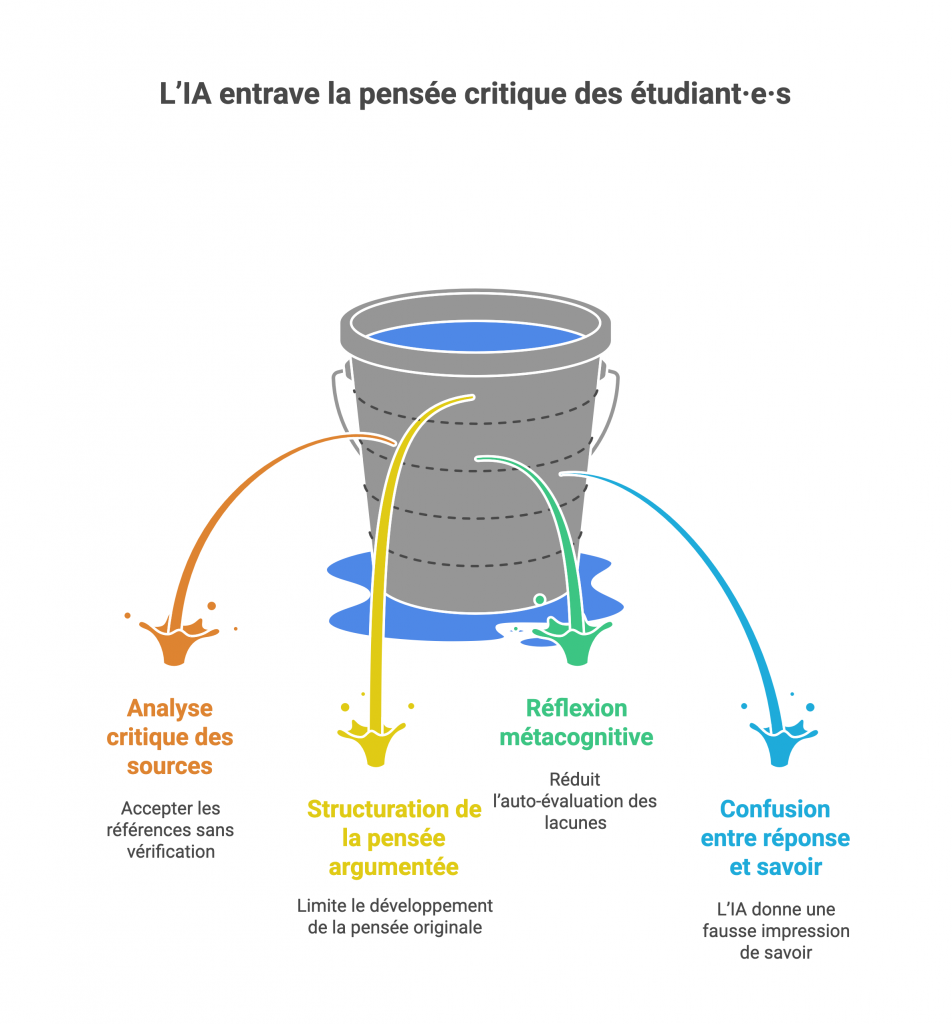

Parmi ces processus que l’IA pourrait court-circuiter :

- L’analyse critique des sources. Si l’IA fournit une réponse avec des références, l’étudiant·e pourrait être tenté·e de les accepter sans les vérifier. Or, il est connu que l’IA peut générer de fausses références ou des citations inexactes mêlées à des vraies. Sans une démarche de vérification systématique de la part de l’apprenant·e, le risque est d’ancrer des connaissances erronées ou non fondées. L’esprit critique doit pousser à demander : d’où vient cette information ? est-elle corroborée ailleurs ?

- La structuration de la pensée argumentée. En proposant des explications toutes faites ou des argumentaires “clé en main”, l’IA peut limiter le développement de la pensée critique et originale de l’étudiant·e. Si chaque fois qu’on pose une question, on obtient un essai bien ficelé, on se prive de l’exercice intellectuel de construire son propre raisonnement, de peser le pour et le contre, de trouver ses exemples. À terme, cela peut réduire la capacité à argumenter de manière autonome et novatrice.

- La réflexion métacognitive sur l’apprentissage. L’apprentissage est renforcé quand l’étudiant·e prend le temps de réfléchir à sa propre compréhension : qu’est-ce que je ne comprends pas ? comment puis-je m’améliorer ? Si l’IA donne tout de suite une réponse, l’apprenant·e risque de moins pratiquer cette auto-évaluation de ses lacunes.L’habitude de la facilité peut entamer l’aptitude à identifier ce qu’on ne sait pas et à planifier des stratégies pour apprendre. Ainsi, l’IA peut donner l’illusion à l’étudiant·e qu’il/elle a acquis une connaissance alors qu’aucun véritable raisonnement n’a eu lieu en lui/elle

- Le danger est de confondre “réponse obtenue” et “savoir acquis”. C’est pourquoi il est indispensable de former les usagers (étudiant·e·s et enseignant·e·s) à une utilisation consciente et maîtrisée de l’IA, en adoptant une posture de vérification et de remise en question systématique.

- En pratique, cela signifie : encourager les étudiant·e·s à douter des réponses de l’IA, à en vérifier la fiabilité (par exemple en cherchant les références fournies), et à s’en servir comme point de départ à une réflexion plutôt que comme vérité absolue. Comme le souligne l’Université de Fribourg, il ne faut pas interdire l’outil mais apprendre à travailler avec, tout en contrôlant les résultats produits car « ils ne sont pas toujours corrects et ne remplaceront pas les réflexions complexes qu’un être humain peut effectuer »

- L’usage de l’IA doit ainsi être accompagné de métacognition : l’étudiant·e devrait se demander en quoi l’IA m’a aidé, et qu’est-ce que j’aurais peut-être manqué sans mon propre esprit critique ?

En somme, pour éviter l’illusion de maîtrise, l’enseignant·e joue un rôle clé : celui de gardien de la pensée critique. Il convient de sensibiliser les étudiant·e·s aux limites de l’IA, de les entraîner à valider une information (recouper avec le cours ou d’autres sources), et de créer des activités qui forcent à dépasser le simple recopiage de la réponse fournie par la machine (voir sections suivantes). L’IA doit être présentée comme un outil d’appui et non comme une oracle infaillible. Cette éducation à l’esprit critique face à l’IA rejoint d’ailleurs le concept d’IA literacy (littératie de l’IA) qui vise à donner à chacun·e les clés pour utiliser intelligemment ces outils (Anders, 2023).

IA comme outil d’accompagnement pédagogique (tuteur virtuel)

Un autre usage émergent de l’IA en éducation est celui de tuteur ou assistant pédagogique virtuel. En théorie, un agent conversationnel sophistiqué peut être disponible 24h/24 pour répondre aux questions des étudiant·e·s, réexpliquer un concept, fournir des exemples supplémentaires, ou même guider l’apprenant·e pas à pas dans la résolution d’un problème.

Ceci fait écho aux idées du psychologue Vygotsky sur la zone proximale de développement : un outil capable d’apporter une aide juste au-dessus du niveau actuel de l’élève pourrait l’aider à progresser. Les IA génératives possèdent en effet le potentiel d’offrir une forme d’assistance : elles peuvent fournir des explications, répondre aux questions, structurer un parcours d’apprentissage, voire aider les étudiant·e·s à produire du matériel d’étude et de révision (fiches, résumés).

Dans l’idéal, on pourrait imaginer un chatbot-tuteur personnalisé pour chaque étudiant·e, comblant certaines lacunes instantanément ou proposant des exercices adaptés. Cette vision attractive d’une IA “mentor” doit cependant être fortement nuancée par la réalité de ses limitations pédagogiques et socio-affectives.

En pratique, plusieurs risques apparaissent lorsqu’on utilise une IA comme tuteur :

Dans l’idéal, on pourrait imaginer un chatbot-tuteur personnalisé pour chaque étudiant·e, comblant certaines lacunes instantanément ou proposant des exercices adaptés. Cette vision attractive d’une IA “mentor” doit cependant être fortement nuancée par la réalité de ses limitations pédagogiques et socio-affectives.

En pratique, plusieurs risques apparaissent lorsqu’on utilise une IA comme tuteur :

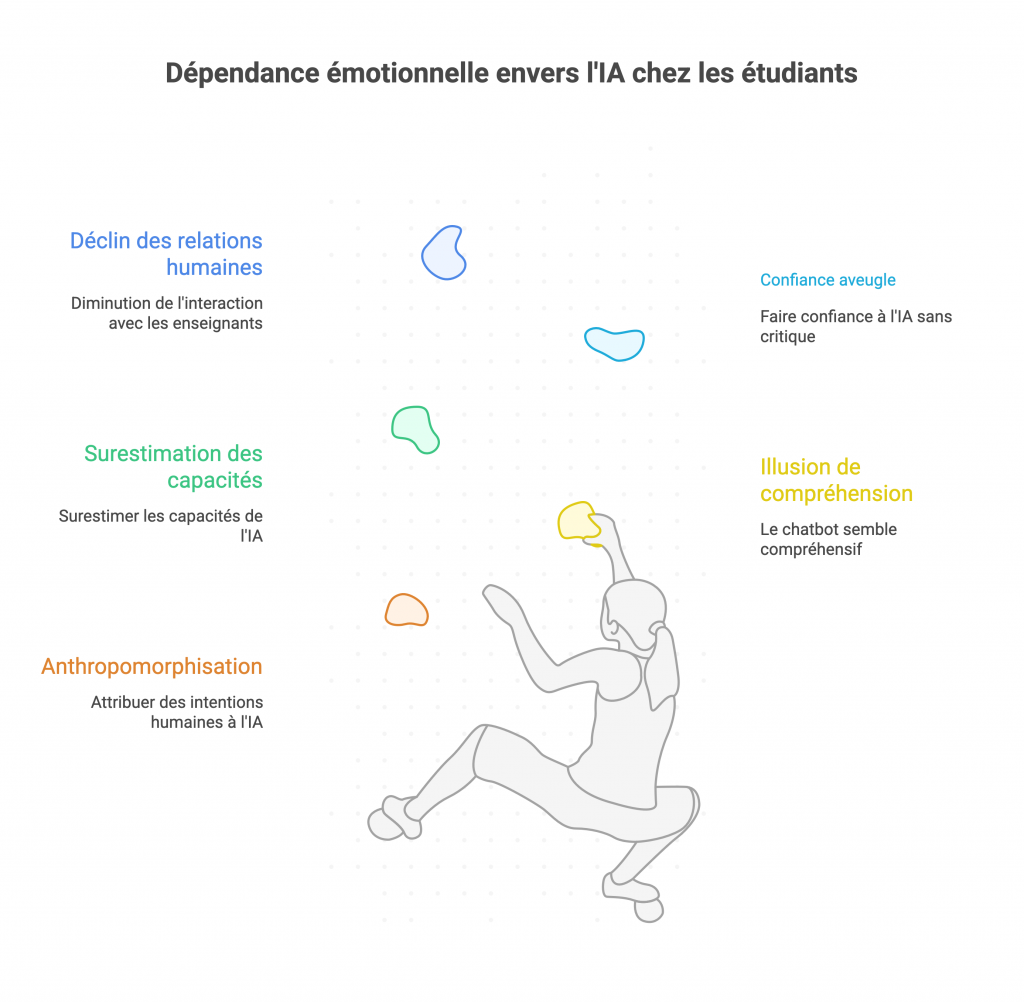

- Anthropomorphisation et dépendance émotionnelle. Les étudiant·e·s ont tendance à anthropomorphiser les IA, c’est-à-dire à leur prêter des intentions ou une intelligence qu’elles n’ont pas. Un chatbot poli et encourageant peut donner l’illusion d’un interlocuteur compréhensif. Certain·e·s étudiant·e·s peuvent alors développer une dépendance socio-affective envers l’IA, la percevant comme un·e mentor bienveillant·e, alors qu’il ne s’agit que d’un algorithme sans conscience ni empathie réelle. Cette illusion de relation pédagogique peut conduire à surestimer les capacités de l’IA et à lui faire une confiance aveugle, au détriment du rapport avec l’enseignant·e humain·e.

- Réduction des interactions humaines. Si l’IA répond à toutes les questions, l’étudiant·e pourrait moins solliciter l’enseignant·e ou discuter avec ses camarades. Or, on sait que le dialogue pédagogique humain – avec les professeurs ou en groupe avec les pairs – est essentiel à l’apprentissage en profondeur. Remplacer ces échanges riches par des interactions avec une IA risque d’appauvrir la dimension interactive et réflexive du processus d’apprentissage. Par exemple, un étudiant qui prépare un examen ne posera plus de questions en cours ou ne participera plus au forum de discussion du fait qu’il obtient déjà toutes ses réponses via ChatGPT ; il se prive ainsi des éclairages supplémentaires, des débats d’idées et du feedback personnalisé qu’un enseignant ou d’autres apprenants pourraient lui apporter.

- Baisse de la tolérance à la frustration. Un·e enseignant·e humain·e sait qu’il faut parfois challenger les étudiant·e·s, les pousser à chercher par eux-mêmes, au risque qu’ils/elles se trompent et apprennent de leurs erreurs. Cette gestion de la frustration productive fait partie du processus éducatif (on apprend aussi en butant sur un problème). L’IA, elle, tend à fournir des réponses immédiates et à lisser les difficultés. À force d’obtenir des solutions instantanées, l’étudiant·e pourrait perdre l’habitude de persévérer face à un concept complexe. Sa résilience cognitive et sa capacité à fournir un effort soutenu peuvent diminuer, ce qui est problématique pour aborder des tâches ardues nécessitant de la patience et de la réflexion.

- Disparition du conflit cognitif. Les théories socioconstructivistes de l’apprentissage soulignent l’importance du conflit cognitif : c’est souvent en confrontant des idées différentes, en débattant, en se trompant, que l’on construit de nouvelles connaissances plus solides. Or, les IA conversationnelles, par conception, cherchent généralement à fournir une réponse concise, neutre et sans controverse (elles évitent de prendre parti ou d’exprimer un désaccord marqué, à moins qu’on ne le leur demande explicitement). Cela signifie que l’IA produit souvent des réponses consensuelles qui ne suscitent pas la contradiction. Un·e étudiant·e qui se contente de l’échange avec l’IA ne vivra pas cette saine confrontation d’idées qu’il aurait eue en débat tantôt avec un enseignant, tantôt avec un pair ayant un point de vue divergent. Le risque est qu’il/elle croit avoir une compréhension aboutie du sujet alors qu’il/elle n’a pas eu à remettre en question ses propres conceptions initiales faute de contradiction de la part de l’IA. En somme, l’IA peut lisser les débats et donner une impression trompeuse d’un savoir “bien rangé”, alors que l’apprentissage gagne souvent à être un processus un peu chaotique fait de désaccords et de remises en cause.

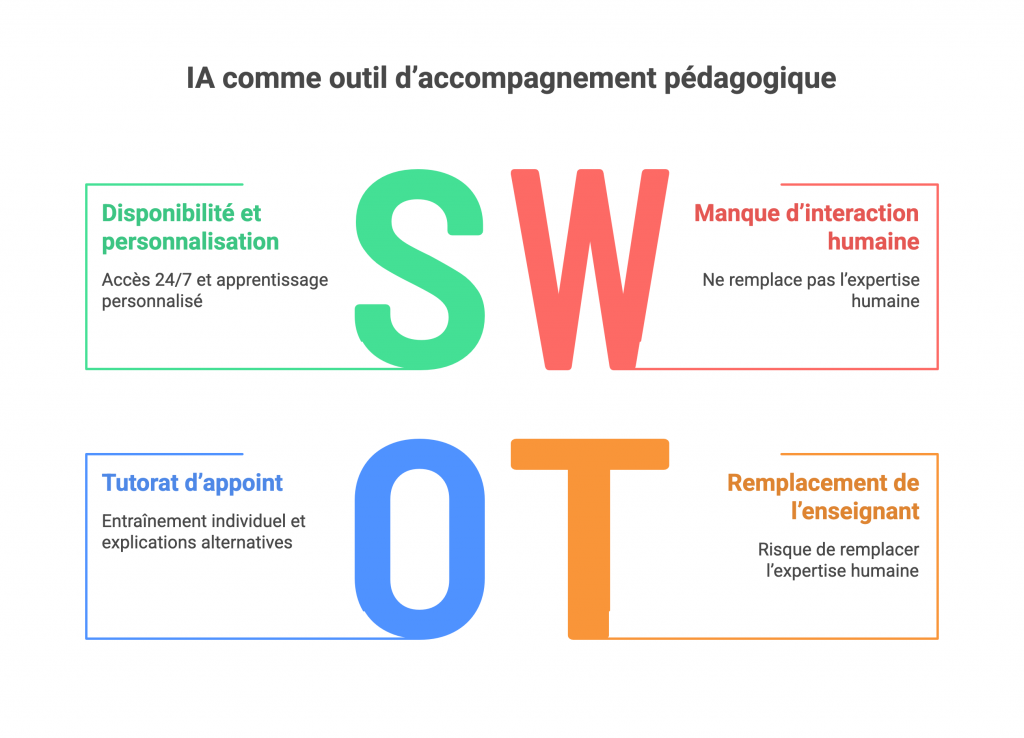

En dépit de ces risques, l’IA peut jouer un rôle d’accompagnement intéressant si son usage est bien encadré. L’idée n’est pas de la laisser remplacer totalement l’enseignant ou le groupe, mais de l’utiliser comme un complément. Par exemple, un chatbot pourrait servir de tuteur d’appoint pour de l’entraînement individuel : l’étudiant·e s’entraîne sur des exercices avec l’IA qui lui explique ses erreurs, puis l’enseignant fait un debriefing en classe pour revenir sur les points mal compris et apporter l’expertise humaine. De même, l’IA pourrait fournir des explications alternatives aux explications du professeur (pour toucher des sensibilités différentes), qui seront ensuite discutées en cours. Le tout est de maintenir l’enseignant·e dans le rôle d’orchestrateur : c’est lui/elle qui pilote l’activité, qui valide ou corrige les apports de l’IA et qui garantit la qualité pédagogique. Il faut également préparer les étudiant·e·s à utiliser un tuteur IA de façon critique : par exemple, encourager l’étudiant·e à challenger l’IA (« qu’est-ce qui se passerait si… ? », « pourrais-tu expliquer autrement ? ») plutôt que d’accepter la première réponse, ou encore lui demander de confronter la réponse de l’IA avec celle d’un camarade pour voir s’il y a des différences. Ainsi, on peut essayer de réintroduire du conflit cognitif et de l’interaction humaine autour de l’outil IA. En résumé, l’IA comme outil d’accompagnement pédagogique offre des avantages (disponibilité, personnalisation, multiplicité d’exemples), mais ne doit pas supplanter l’interaction humaine ni dispenser l’effort de réflexion. Son usage nécessite un dosage équilibré, en gardant à l’esprit qu’un chatbot, si sophistiqué soit-il, n’a pas la richesse d’un être humain dans l’acte d’enseigner. Le rôle socio-affectif de l’enseignant·e, sa capacité à inspirer, à motiver, à corriger avec empathie, reste irremplaçable.

IA et production académique : entre assistance et substitution

Un troisième impact de l’IA dans l’enseignement supérieur concerne la production des travaux académiques (devoirs, rapports, mémoires, etc.) par les étudiant·e·s. En effet, ChatGPT et consorts peuvent désormais générer des dissertations, des codes informatiques, des résumés, etc., avec une telle aisance que certain·e·s étudiant·e·s sont tenté·e·s de les utiliser pour faire (ou aider à faire) leurs travaux écrits. Cela pose toute une série de questions pédagogiques et éthiques : quel apprentissage si l’IA fait le travail à la place de l’étudiant·e ? Comment évaluer la part de l’étudiant·e ? Est-ce du plagiat ou de la triche ? Faut-il l’interdire ou l’autoriser ? Dans cette section, nous examinerons d’abord les risques cognitifs d’une délégation excessive à l’IA, puis les enjeux d’intégrité académique, avant de voir quelles stratégies on peut adopter pour trouver un équilibre entre usage bénéfique et usage problématique de l’IA dans les travaux étudiants.

- Risques cognitifs et “délégation” du travail intellectuel. Confier à l’IA le soin de rédiger un devoir à sa place peut sembler un gain de temps, mais c’est surtout une perte d’opportunité d’apprentissage pour l’étudiant·e. En laissant l’IA faire, l’étudiant·e renonce à une partie du processus intellectuel qui était visé par l’exercice.

- Passivité intellectuelle et non-intériorisation des savoirs. Lorsque l’IA rédige une dissertation ou un essai, l’étudiant·e ne s’approprie pas les concepts mobilisés. Il/elle n’a pas eu à reformuler avec ses propres mots, à chercher l’information, à la sélectionner puis la synthétiser. Or, c’est précisément en faisant cet effort de reformulation et de structuration qu’on consolide ses connaissances. L’IA fournit un produit fini, mais l’étudiant·e n’a pas traversé le chemin de pensée qui construit le savoir. Cela entraîne une diminution de la pensée critique, l’étudiant·e acceptant sans remise en question le texte généré. On observe aussi un déficit dans l’acquisition des connaissances : ne pas avoir manipulé activement les idées, c’est risquer de les oublier vite ou de ne pas savoir les mobiliser dans un contexte différent.

- A force de déléguer la rédaction, l’étudiant·e perd l’entraînement de compétences fondamentales comme la recherche documentaire, l’analyse et la synthèse d’informations, ou la structuration logique d’un écrit.Ces compétences rédactionnelles sont pourtant essentielles pour structurer et transmettre une réflexion, et se révèlent précieuses bien au-delà de l’université. En somme, utiliser l’IA comme raccourci cognitif prive l’étudiant·e de l’exercice même qui était le but pédagogique de l’évaluation.

- La “fabrique du plausible” et le risque d’erreurs non détectées. Les modèles d’IA générative excellent à produire du texte fluide et vraisemblable. Cependant, plausible ne veut pas dire juste. L’IA peut intégrer dans un devoir des erreurs subtiles (dates incorrectes, interprétations biaisées, calculs faux) tout en gardant un style convaincant. Un·e étudiant·e peu au fait du sujet pourrait ne pas discerner ces erreurs et remettre un travail contenant des contre-vérités. Ce faisant, il/elle intègre ces erreurs dans sa propre compréhension du sujet, les validant par le simple fait de les avoir utilisées. C’est le risque de contamination cognitive : à force de lire et relire un texte erroné pour le peaufiner, on finit par croire à son contenu. L’IA est une usine à plausible : elle va toujours vous donner quelque chose qui “a l’air” vrai. Cela demande d’autant plus de vigilance de la part de l’étudiant·e (et de l’enseignant·e qui corrigera) pour débusquer l’erreur cachée. L’étudiant·e qui s’appuie sur l’IA doit donc être formé·e à relire de façon critique ce que l’IA produit, ce qui n’est pas une mince affaire quand on débute dans un domaine.

- Atteinte à l’intégrité de l’apprentissage. Sur le plan éthique, si un travail est rendu comme étant personnel alors qu’il a été en grande partie rédigé par une IA, on peut parler de fraude ou à minima de malhonnêteté académique. Cela soulève la question : un texte produit par l’IA et utilisé tel quel constitue-t-il un plagiat ou une triche ? Les règles académiques actuelles n’ont pas toutes anticipé ce cas de figure. Il devient urgent pour les institutions d’enseignement supérieur de clarifier leur position à ce sujet. Au minimum, il semble nécessaire de distinguer les usages légitimes (par exemple : utiliser l’IA comme source d’inspiration, pour se relire, ou pour brainstormer des idées) des usages problématiques (par exemple : générer intégralement un devoir et le soumettre comme si c’était sa propre production). Sans cela, les étudiant·e·s avancent en terrain flou, certains pensant ne rien faire de mal en s’aidant “un peu beaucoup” de l’IA, d’autres se culpabilisant peut-être à tort pour un simple usage d’assistance orthographique.

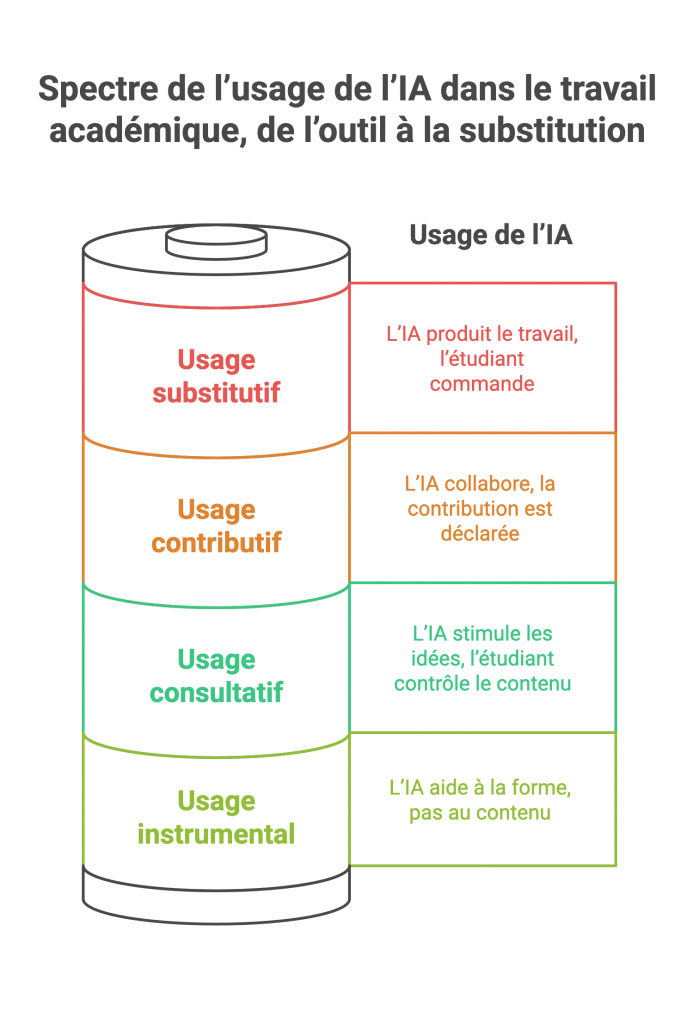

Les points précédents montrent que les frontières entre création originale, assistance et délégation cognitive deviennent floues à l’ère de l’IA. Plutôt que de raisonner en tout ou rien (autoriser totalement l’IA ou l’interdire complètement), il est plus pertinent d’adopter une approche nuancée. Des expert·e·s proposent d’élaborer une gradation des usages de l’IA dans les travaux académiques.

Par exemple, on peut distinguer :

- Usage instrumental : l’IA est utilisée comme un outil technique sans impact sur le contenu intellectuel du travail. Exemples : corriger l’orthographe/grammaire, mettre en forme un texte, faire de la vérification de références. C’est un usage comparable à un logiciel comme Grammarly ou Antidote, qui n’apporte pas d’idées mais aide juste à la forme. Cet usage est généralement considéré comme acceptable, au même titre qu’utiliser un correcteur automatique.

- Usage consultatif : l’IA sert de partenaire de réflexion pour stimuler les idées, sans se substituer à l’auteur. Par exemple, on discute avec ChatGPT pour recueillir des pistes sur un sujet, on lui pose des questions pour éclaircir un concept, mais in fine l’étudiant·e rédige le texte final avec ses propres mots et idées. Ici, l’IA est une sorte de sparring-partner intellectuel, ce qui peut être vu comme un usage tolérable (certains y verront même une forme d’apprentissage) tant que l’étudiant·e reste en contrôle du contenu.

- Usage contributif : l’IA est une collaboratrice assumée, qui génère une part significative du contenu, mais cette contribution est encadrée et déclarée. Par exemple, un étudiant peut demander à l’IA d’écrire un paragraphe explicatif qu’il intégrera ensuite dans son devoir, en le signalant clairement (« paragraphe généré avec tel outil, revu par mes soins »). On pourrait assimiler cela à un travail de co-auteur entre l’étudiant et l’IA. C’est évidemment un terrain délicat : on sort de l’exercice purement personnel, mais si c’est fait avec transparence et encadrement (et par exemple autorisé par l’enseignant pour cet exercice précis), cela pourrait être accepté dans certains contextes. Il faudrait alors adapter l’évaluation en conséquence (voir section 5 sur l’évaluation).

- Usage substitutif : l’IA est le producteur principal du travail, l’étudiant·e se contentant grosso modo d’être le commanditaire. C’est le cas d’un devoir quasi entièrement rédigé par ChatGPT et remis tel quel (ou très légèrement remanié) par l’étudiant·e. Ici, il y a clairement délégation du travail intellectuel : l’étudiant·e n’a pas accompli la tâche cognitive attendue, ce qui pose un problème pédagogique (pas d’apprentissage réel) et éthique (forme de tricherie). Cet usage est à considérer comme inacceptable dans le cadre d’un travail noté, au même titre que du plagiat classique.

Entre ces catégories, on peut imaginer des gradients. L’important est de poser explicitement les limites dans chaque contexte (chaque cours, chaque institution) : qu’est-ce qui est permis, qu’est-ce qui ne l’est pas. Par exemple, un enseignant pourra dire à ses étudiant·e·s : « Pour ce devoir, vous pouvez utiliser ChatGPT pour vous aider à trouver des idées (usage consultatif), mais tout passage de texte généré doit être réécrit avec vos mots et il est interdit de le laisser tel quel (pas d’usage substitutif). » Un autre pourra autoriser l’usage contributif sous condition de joindre en annexe le brouillon sorti de l’IA et d’écrire une réflexion sur comment l’IA a été utilisée. Un autre encore choisira d’interdire totalement l’IA pour un travail donné (usage instrumental compris) si le but est d’évaluer la capacité brute de l’étudiant·e sans aide.