Jean-François (Jeff) Van de Poël – Projet de recherche en cours, partage état Octobre 2025

This work is licensed under CC BY-NC-SA 4.0

Introduction

Les progrès rapides de l’intelligence artificielle mettent en évidence une nouvelle forme de répartition des tâches cognitives : l’être humain et la machine interviennent désormais comme partenaires aux compétences complémentaires plutôt qu’en substituts concurrents.

Dans ce paysage, plusieurs recherches convergent pour décrire la cognition comme partagée entre deux agents distincts. Siemens, Dawson et Gašević parlent d’un « espace de coordination » dans lequel l’intelligence humaine et l’intelligence artificielle s’articulent selon la nature du problème rencontré et le degré d’incertitude qu’il comporte . Sur le plan organisationnel, Jarrahi définit cette configuration comme une « symbiose décisionnelle » : l’IA traite des volumes d’information rapidement, tandis que l’humain mobilise son intuition, son sens moral et sa compréhension contextuelle pour orienter ou corriger les résultats.

Comprendre la compétence sous l’angle de cette co-agence (toujours menée par l’humain !) conduit à s’interroger sur la manière dont les formations peuvent préparer les apprenant·e·s à orchestrer le dialogue avec les systèmes d’IA plutôt qu’à les imiter. Dans l’enseignement supérieur, les travaux portant sur la collaboration humain-IA insistent sur le fait qu’un apprentissage efficace suppose la mise en place de mécanismes de « régulation conjointe » : l’IA fournit une assistance immédiate, mais l’étudiant·e reste responsable du cadrage, de la validation et de l’intégration des connaissances produites. La compétence se construit alors comme un processus dynamique où chacun — humain et IA — apporte des ressources cognitives spécifiques.

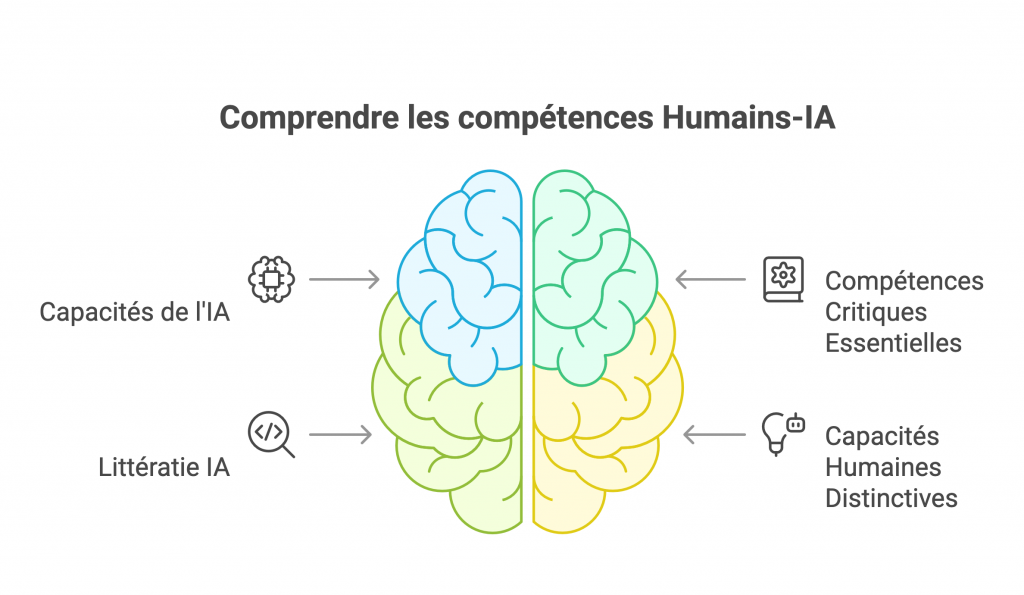

Pour rendre ce processus descriptible et actionnable, le cadre quadridimensionnel des compétences hybrides humaines-IA propose de distinguer quatre domaines :

- les capacités propres de l’IA,

- les compétences et connaissances essentielles de vérification critique,

- la littératie IA entendue comme aptitude à interagir avec l’outil,

- les capacités humaines distinctives qui demeurent hors de portée des algorithmes actuels.

Adopter ces dimensions revient d’abord à reconnaître que la production automatique de contenus n’épuise pas la notion de compétence. La machine peut générer un texte argumenté ou dresser une traduction fluide, mais elle n’attribue de sens à ces productions qu’en fonction d’un objectif défini par l’humain. La première dimension — les capacités de l’IA — sert donc de repère pour savoir ce qui peut être confié à l’algorithme. La deuxième dimension — les compétences essentielles — rappelle que toute production doit être confrontée à un socle disciplinaire, méthodologique et normatif assurant sa fiabilité. Sans cette étape de validation, la relation devient une simple délégation sans contrôle. La troisième dimension — la littératie IA — correspond aux gestes professionnels qui permettent de configurer, d’interroger ou de détourner l’outil. Les étudiants apprennent à formuler des requêtes, à interpréter un score de confiance, à expliciter les limites d’une réponse algorithmique. Enfin, la quatrième dimension — les capacités humaines distinctives — regroupe des habiletés comme le sens critique, la créativité conceptuelle, l’empathie ou le jugement moral, indispensables pour relier l’usage de l’IA à des finalités sociales et éthiques.

Quel est l’intérêt de structurer la réflexion selon ces quatre entrées ?

Premièrement, cela permet de clarifier les responsabilités : la machine assume les opérations pour lesquelles elle est performante, l’humain conserve la décision finale ainsi que la charge morale et sociale qui l’accompagne. Deuxièmement, ce découpage facilite la conception de programmes de formation en identifiant, pour chaque domaine, des objectifs pédagogiques et des modalités d’évaluation adaptées. Par exemple, l’apprentissage de la littératie IA peut se traduire par des ateliers de formulation de prompts ou par des exercices de documentation de la traçabilité, alors que le développement des capacités humaines distinctives passera plutôt par des débats éthiques ou des projets interdisciplinaires. Troisièmement, le cadre ouvre un espace de recherche empirique : chaque dimension peut faire l’objet de mesures spécifiques (qualité du raisonnement critique, robustesse des validations, efficience de l’orchestration métacognitive) et être corrélée à la performance globale de la collaboration humain-IA.

Repenser les compétences à la lumière de cette grille n’implique pas de hiérarchiser humain et machine, mais de les situer dans une relation d’interdépendance explicite. La notion de cognition distribuée rappelle que la connaissance résulte moins des capacités internes d’un seul agent que des interactions entre plusieurs acteurs, artefacts et contextes. Dans ce cadre, le rôle de l’éducation n’est plus de transmettre un stock de savoirs qu’un modèle peut reproduire ; il est d’enseigner à mobiliser, combiner et évaluer des ressources dispersées, qu’elles soient humaines, sociales ou algorithmiques. Les quatre dimensions du cadre offrent une cartographie pour organiser cette mobilisation : déterminer ce qui relève de l’automatisation, ce qui exige une validation experte, ce qui dépend d’une interaction technique éclairée et ce qui requiert une position éthique et créative.

En plaçant la relation humain-IA au centre de l’analyse, le cadre invite enfin à une vigilance continue : toute évolution des modèles, des normes ou des attentes sociales peut redistribuer la part respective des dimensions. Il appartient donc aux institutions de formation de maintenir une observation active de ces évolutions afin d’ajuster les curricula et de garantir la pertinence durable des compétences développées. Ainsi structurée, l’approche permet de concilier les apports des technologies émergentes avec la nécessité de préserver l’autonomie intellectuelle et la responsabilité sociale qui demeurent, pour l’instant, au cœur de l’activité humaine.

Dimension 1 : Capacités de l’IA et exécution des tâches

Au sein du cadre quadridimensionnel, la première dimension sert de baromètre pour mesurer ce qu’un système d’intelligence artificielle accomplit de façon autonome ou sous supervision humaine minimale. Délimiter ces capacités n’a pas seulement une fonction descriptive ; c’est un préalable pour décider quelles portions d’un curriculum doivent être reconfigurées afin de privilégier l’analyse, l’interprétation et le jugement plutôt que la simple production mécanique. La liste initiale—génération de contenu, synthèse d’information, reconnaissance de formes, traduction et modélisation prédictive—constitue la base de référence.

Depuis 2024, plusieurs évolutions techniques exigent d’amender cette cartographie sans en bouleverser l’esprit. Les modèles dits « omnimodaux » traitent et génèrent texte, image et audio dans un même flux, réduisant la latence conversationnelle à quelques centaines de millisecondes, comme l’atteste la GPT-4o System Card. Parallèlement, l’extension des fenêtres de contexte (200 000 tokens pour Claude 3 permet la synthèse d’ensembles documentaires jusqu’alors hors de portée. Enfin, la diffusion de modèles open source performants tels que Llama 3 étend ces fonctionnalités à des infrastructures locales, favorisant les expérimentations disciplinaires dans des environnements maîtrisés .

Conserver la structure d’origine tout en l’enrichissant revient donc à préciser, pour chaque tâche, les nouvelles formes qu’elle peut prendre. Cette actualisation dynamique aide les enseignants à identifier les segments d’activité qu’il devient pertinent de déléguer, ceux qui requièrent une double vérification humaine, et ceux qui demeurent indéléguables en raison de contraintes éthiques, contextuelles ou créatives.

Liste des capacités IA principales

- Génération de contenu

- Texte, code, supports visuels et éléments audio produits en flux multimodal quasi synchrone.

- Synthèse et résumé de l’information

- Traitement de corpus étendus (≥ 200 k tokens) avec mise en forme argumentative ou tabulaire adaptée au contexte.

- Reconnaissance des formes et analyse de données

- Détection de motifs cross-modalités (image–texte, image–audio) et extraction d’anomalies statistiques.

- Traduction et traitement des langues

- Conversion multilingue incluant prosodie et ton, prise en charge de langues à faibles ressources.

- Simulation et modélisation prédictive

- Scénarios « what-if » orchestrés via appels d’outils externes (Python, calcul matriciel) intégrés dans le dialogue.

- Interaction conversationnelle omnicanal

- Dialogue voix-texte-image avec latence inférieure à 500 ms, possibilité de tutorat adaptatif.

- Chaînage d’actions via function calling

- Orchestration d’API (recherche, base de données, messagerie) au sein d’une même session de génération.

- Agentivité autonome sous supervision

- Exécution de boucles de planification-action-révision sur des tâches définies, avec contrôle de fin par l’utilisateur.

- Extraction et structuration de connaissances

- Conversion de notes brutes en bases de données ou graphes de concepts interrogeables.

Au sein du cadre quadridimensionnel, la première dimension sert de baromètre pour mesurer ce qu’un système d’intelligence artificielle accomplit de façon autonome ou sous supervision humaine minimale. Délimiter ces capacités n’a pas seulement une fonction descriptive ; c’est un préalable pour décider quelles portions d’un curriculum doivent être reconfigurées afin de privilégier l’analyse, l’interprétation et le jugement plutôt que la simple production mécanique. La liste initiale—génération de contenu, synthèse d’information, reconnaissance de formes, traduction et modélisation prédictive—constitue la base de référence.

Depuis 2024, plusieurs évolutions techniques exigent d’amender cette cartographie sans en bouleverser l’esprit. Les modèles dits « omnimodaux » traitent et génèrent texte, image et audio dans un même flux, réduisant la latence conversationnelle à quelques centaines de millisecondes, comme l’atteste la GPT-4o System Card. Parallèlement, l’extension des fenêtres de contexte (200 000 tokens pour Claude 3 permet la synthèse d’ensembles documentaires jusqu’alors hors de portée. Enfin, la diffusion de modèles open source performants tels que Llama 3 étend ces fonctionnalités à des infrastructures locales, favorisant les expérimentations disciplinaires dans des environnements maîtrisés .

Conserver la structure d’origine tout en l’enrichissant revient donc à préciser, pour chaque tâche, les nouvelles formes qu’elle peut prendre. Cette actualisation dynamique aide les enseignants à identifier les segments d’activité qu’il devient pertinent de déléguer, ceux qui requièrent une double vérification humaine, et ceux qui demeurent indéléguables en raison de contraintes éthiques, contextuelles ou créatives.

Liste des capacités IA principales

- Génération de contenu

- Texte, code, supports visuels et éléments audio produits en flux multimodal quasi synchrone.

- Synthèse et résumé de l’information

- Traitement de corpus étendus (≥ 200 k tokens) avec mise en forme argumentative ou tabulaire adaptée au contexte.

- Reconnaissance des formes et analyse de données

- Détection de motifs cross-modalités (image–texte, image–audio) et extraction d’anomalies statistiques.

- Traduction et traitement des langues

- Conversion multilingue incluant prosodie et ton, prise en charge de langues à faibles ressources.

- Simulation et modélisation prédictive

- Scénarios « what-if » orchestrés via appels d’outils externes (Python, calcul matriciel) intégrés dans le dialogue.

- Interaction conversationnelle omnicanal

- Dialogue voix-texte-image avec latence inférieure à 500 ms, possibilité de tutorat adaptatif.

- Chaînage d’actions via function calling

- Orchestration d’API (recherche, base de données, messagerie) au sein d’une même session de génération.

- Agentivité autonome sous supervision

- Exécution de boucles de planification-action-révision sur des tâches définies, avec contrôle de fin par l’utilisateur.

- Extraction et structuration de connaissances

- Conversion de notes brutes en bases de données ou graphes de concepts interrogeables.

Dimension 2 — Compétences conceptuelles essentielles

Dans des contextes d’apprentissage où les systèmes d’IA générative fournissent désormais brouillons, traductions ou synthèses en quelques secondes, l’utilité pédagogique se déplace vers ce que les étudiant·e·s doivent encore produire sans recours algorithmique : une évaluation raisonnée de la fiabilité, de la pertinence et des limites des informations obtenues. Les « compétences essentielles de vérification critique » désignent ici l’ensemble des savoirs et des dispositions qui permettent d’examiner, de contextualiser et, au besoin, de contester toute affirmation, qu’elle provienne d’une source traditionnelle ou d’un modèle de langage. Cette approche prolonge les cadres internationaux de littératie IA : EDUCAUSE souligne que la capacité d’« évaluation critique » conditionne l’usage responsable des outils, tandis que l’UNESCO inscrit la « pensée critique » et la « responsabilité » parmi les compétences fondamentales à acquérir. Dans la recherche en sciences cognitives, Sperber et ses collègues décrivent cette vigilance comme un mécanisme de « surveillance épistémique » permettant de calibrer la confiance accordée à chaque information.

Ces compétences se structurent autour de trois finalités. D’abord, valider la solidité interne : cohérence logique, justesse méthodologique, adéquation aux cadres théoriques de la discipline. Ensuite, vérifier la provenance : identification des auteurs, analyse des biais, appréciation de la qualité des données sous-jacentes. Enfin, situer l’énoncé dans son contexte socio-éthique et réglementaire : conformité aux règles de droit (p. ex. AI Act pour les outils à haut risque), mais aussi pertinence par rapport aux valeurs et aux finalités de la communauté académique. Préparer les étudiant·e·s à ces trois opérations revient à préserver leur autonomie intellectuelle ; c’est également une exigence professionnelle, les expertises de vérification devenant un marqueur de crédibilité dans la plupart des secteurs confrontés aux flux informationnels amplifiés par l’IA.

Liste des compétences essentielles

- Culture disciplinaire et méthodologie

- Maîtriser les cadres théoriques, les méthodes de preuve et les standards d’écriture de la discipline afin de situer tout résultat IA dans un référentiel savant robuste.

- Recherche et évaluation des sources

- Identifier l’origine d’un document, examiner l’autorité de l’auteur·e, dater et croiser les informations pour réduire la dépendance à une source unique.

- Triangulation et corroboration

- Confronter plusieurs corpus, jeux de données ou points de vue indépendants avant d’acter une conclusion ; intégrer les discordances comme éléments d’analyse.

- Raisonnement argumentatif et logique

- Construire une chaîne d’arguments explicite ; repérer les sophismes, contradictions ou inférences non justifiées.

- Vigilance épistémique

- Réguler le degré de confiance accordé à une information en fonction d’indices de fiabilité et de coûts potentiels de l’erreur.

- Cadres éthiques et réglementaires

- Appliquer les exigences relatives à la protection des données, à l’équité et à la transparence ; connaître les catégories de risque définies par l’AI Act pour situer les enjeux de responsabilité.

- Métacognition et autorégulation

- Planifier les tâches de contrôle, auto-évaluer la solidité de son raisonnement, ajuster ses stratégies lorsque de nouvelles informations surgissent.

- Documentation et traçabilité

- Consigner les étapes de vérification, archiver les versions de textes ou de données, fournir une bibliographie structurée et des notes méthodologiques accessibles.

- Communication critique et responsable

- Présenter de façon claire les forces, limites et incertitudes d’un travail ; argumenter les décisions méthodologiques devant un public académique ou professionnel.

Dans des contextes d’apprentissage où les systèmes d’IA générative fournissent désormais brouillons, traductions ou synthèses en quelques secondes, l’utilité pédagogique se déplace vers ce que les étudiant·e·s doivent encore produire sans recours algorithmique : une évaluation raisonnée de la fiabilité, de la pertinence et des limites des informations obtenues. Les « compétences essentielles de vérification critique » désignent ici l’ensemble des savoirs et des dispositions qui permettent d’examiner, de contextualiser et, au besoin, de contester toute affirmation, qu’elle provienne d’une source traditionnelle ou d’un modèle de langage. Cette approche prolonge les cadres internationaux de littératie IA : EDUCAUSE souligne que la capacité d’« évaluation critique » conditionne l’usage responsable des outils, tandis que l’UNESCO inscrit la « pensée critique » et la « responsabilité » parmi les compétences fondamentales à acquérir. Dans la recherche en sciences cognitives, Sperber et ses collègues décrivent cette vigilance comme un mécanisme de « surveillance épistémique » permettant de calibrer la confiance accordée à chaque information.

Ces compétences se structurent autour de trois finalités. D’abord, valider la solidité interne : cohérence logique, justesse méthodologique, adéquation aux cadres théoriques de la discipline. Ensuite, vérifier la provenance : identification des auteurs, analyse des biais, appréciation de la qualité des données sous-jacentes. Enfin, situer l’énoncé dans son contexte socio-éthique et réglementaire : conformité aux règles de droit (p. ex. AI Act pour les outils à haut risque), mais aussi pertinence par rapport aux valeurs et aux finalités de la communauté académique. Préparer les étudiant·e·s à ces trois opérations revient à préserver leur autonomie intellectuelle ; c’est également une exigence professionnelle, les expertises de vérification devenant un marqueur de crédibilité dans la plupart des secteurs confrontés aux flux informationnels amplifiés par l’IA.

Liste des compétences essentielles

- Culture disciplinaire et méthodologie

- Maîtriser les cadres théoriques, les méthodes de preuve et les standards d’écriture de la discipline afin de situer tout résultat IA dans un référentiel savant robuste.

- Recherche et évaluation des sources

- Identifier l’origine d’un document, examiner l’autorité de l’auteur·e, dater et croiser les informations pour réduire la dépendance à une source unique.

- Triangulation et corroboration

- Confronter plusieurs corpus, jeux de données ou points de vue indépendants avant d’acter une conclusion ; intégrer les discordances comme éléments d’analyse.

- Raisonnement argumentatif et logique

- Construire une chaîne d’arguments explicite ; repérer les sophismes, contradictions ou inférences non justifiées.

- Vigilance épistémique

- Réguler le degré de confiance accordé à une information en fonction d’indices de fiabilité et de coûts potentiels de l’erreur.

- Cadres éthiques et réglementaires

- Appliquer les exigences relatives à la protection des données, à l’équité et à la transparence ; connaître les catégories de risque définies par l’AI Act pour situer les enjeux de responsabilité.

- Métacognition et autorégulation

- Planifier les tâches de contrôle, auto-évaluer la solidité de son raisonnement, ajuster ses stratégies lorsque de nouvelles informations surgissent.

- Documentation et traçabilité

- Consigner les étapes de vérification, archiver les versions de textes ou de données, fournir une bibliographie structurée et des notes méthodologiques accessibles.

- Communication critique et responsable

- Présenter de façon claire les forces, limites et incertitudes d’un travail ; argumenter les décisions méthodologiques devant un public académique ou professionnel.

Dimension 3 — Littératie IA

La littératie IA désigne l’ensemble des connaissances, aptitudes et dispositions qui permettent d’interagir de manière informée, critique et responsable avec les systèmes d’intelligence artificielle. Dans l’enseignement supérieur, le cadre EDUCAUSE AI Literacy in Teaching & Learning décrit cette compétence comme la capacité à (1) comprendre les bases du fonctionnement de l’IA, (2) évaluer de façon critique ses usages, (3) appliquer l’outil dans des situations authentiques et (4) se prémunir contre ses dérives. L’UNESCO, de son côté, répartit douze compétences étudiantes en quatre groupes similaires, insistant sur la sûreté, la responsabilité et l’engagement citoyen.

Dans les curricula, cette dimension se distingue des « compétences essentielles » précédemment énoncées : ces dernières visent la validation d’un contenu, tandis que la littératie IA concerne la capacité à dialoguer avec l’outil, à paramétrer ses réponses et à réguler ses effets. Les deux registres restent toutefois interdépendants : sans littératie, l’étudiant ne peut mobiliser ses connaissances disciplinaires pour formuler des requêtes pertinentes ; sans socle disciplinaire, la maîtrise technique du modèle risque de se limiter à une manipulation superficielle. Les catégories ci-après reprennent les quatre axes de votre modèle et les actualisent à la lumière de la littérature 2024-2025, notamment les travaux récents sur le prompt engineering en éducation et les analyses internationales de l’état de l’AI literacy.

Catégories de littératie

- Compréhension technique

- Principes de base des modèles (données d’entraînement, inférence probabiliste, fenêtrage de contexte).

- Lecture de documents fournisseurs : system cards, notes de version, métriques de performance.

- Évaluation critique

- Identification des biais potentiels, analyse de la pertinence des sources internes ou externes au modèle.

- Appréciation du niveau de confiance à accorder aux sorties en fonction de l’usage prévu.

- Application pratique

- Élaboration de prompts et de chaînes de requêtes (RAG, function calling) pour résoudre un problème défini.

- Intégration de l’IA dans des flux de travail disciplinaires tout en documentant le processus.

- Considérations éthiques et sociotechniques

- Connaissance des obligations réglementaires (AI Act, RGPD) et des principes d’équité, de transparence et de durabilité.

- Réflexion sur l’impact social, environnemental et professionnel des décisions prises avec l’IA.

Dimension 4 – Les capacités humaines distinctives

L’essor des modèles de langage et des agents autonomes amène à déplacer une part substantielle du travail analytique vers des processus automatisés ; toutefois, il met aussi en évidence les limites persistantes de l’intelligence computationnelle lorsqu’il s’agit d’interpréter une situation ouverte, de gérer des relations sociales ou de décider dans l’incertitude. La littérature consacrée à la collaboration humain-IA emploie le terme co-agency pour décrire l’articulation de deux systèmes cognitifs aux propriétés différentes : la machine excelle dans le calcul à grande échelle, l’humain conserve une supériorité dans l’intégration contextuelle, l’évaluation normative et la création de sens . Les travaux issus de la psychologie organisationnelle montrent, par exemple, que la valeur d’un résultat hybride dépend moins de la capacité brute du modèle que de la faculté des acteurs humains à orienter la tâche, à reconnaître la pertinence d’une suggestion algorithmique et à décider de l’abandonner ou de la transformer lorsque les conditions évoluent .

La notion de capacité humaine distinctive renvoie ainsi à des compétences que l’IA ne réalise pas de manière autonome : donner sens à des signaux faibles, concevoir des cadres interprétatifs inédits, arbitrer entre des valeurs incompatibles, créer la confiance au sein d’un collectif. Dans les recherches sur le sense-making, Weick souligne que l’interprétation d’un environnement ambigu exige un aller-retour continu entre expérience vécue, connaissances tacites et récits partagés . Or la majorité des modèles génératifs opèrent hors de ce cycle incarné ; ils recombinent des régularités issues de corpus passés sans interaction directe avec le contexte immédiat. De même, la créativité conceptuelle — c’est-à-dire la capacité à établir des rapprochements inhabituels entre domaines éloignés ou à modifier les règles du problème — reste difficile à formaliser en apprentissage automatique, sauf sous formes de variations statistiquement plausibles.

La responsabilité morale offre un autre exemple de dissymétrie fonctionnelle. Lorsque des systèmes de recommandation clinique ou financière suggèrent un choix, les recherches en éthique appliquée rappellent que la légitimité finale repose sur un agent humain capable d’assumer les conséquences de la décision . Cette charge implique l’évaluation de dimensions qui ne sont pas entièrement capturées par les données : la vulnérabilité des personnes concernées, l’équité de la procédure ou la compatibilité avec des normes juridiques locales. Dans les milieux professionnels, la coexistence d’équipes mixtes — constituées de personnes et d’agents algorithmiques — fait apparaître un besoin croissant de compétences relationnelles : empathie, négociation, leadership distribué . Ces qualités soutiennent la confiance, essentielle pour exploiter efficacement les capacités de l’IA sans générer de dépendance ni de résistance.

Enfin, plusieurs études soulignent l’importance de l’orchestration métacognitive, définie comme la capacité à planifier, surveiller et ajuster la contribution respective de l’humain et de la machine tout au long d’un processus. Cette compétence inclut la reconnaissance des situations où l’assistance algorithmique apporte un bénéfice (vitesse, exhaustivité) mais aussi celles où elle risque d’introduire des biais ou de masquer des signaux contextuels importants. Elle suppose la construction de règles de passage : moments explicites où l’autorité décisionnelle revient de l’IA à l’opérateur humain, et inversement.

Placer ces capacités humaines distinctives au cœur de la formation répond donc à un double objectif. D’une part, il s’agit de garantir que l’automatisation ne dilue pas l’autonomie intellectuelle ni la responsabilité sociale ; d’autre part, il convient de doter les apprenants de ressources cognitives aptes à complémenter, plutôt qu’à répliquer, les forces de l’intelligence artificielle. La présente dimension encapsule ces exigences en identifiant les domaines où l’investissement pédagogique demeure indispensable pour maintenir une collaboration équilibrée et fiable entre humains et systèmes d’IA.

Liste des capacités humaines distinctives

- Sense-making holistique

- Détecter et relier des signaux faibles ou contradictoires pour construire des interprétations situées.

- Créativité conceptuelle

- Élaborer des cadres, métaphores ou hypothèses inédites afin d’orienter ou de dépasser les propositions de l’IA.

- Jugement moral et responsabilité

- Apprécier les implications éthiques, juridiques et sociales d’une décision assistée par IA et en assumer la charge.

- Empathie et leadership relationnel

- Maintenir la confiance, la motivation et l’alignement des parties prenantes dans des équipes où interviennent des agents algorithmiques.

- Synthèse interdisciplinaire

- Combiner des savoirs de domaines hétérogènes pour créer des solutions ou des analyses que l’IA n’aurait pas inférées.

- Orchestration métacognitive

- Planifier, surveiller et ajuster l’ampleur de l’intervention de l’IA tout au long d’un processus de travail.

- Connaissance incarnée et contextuelle

- Mobiliser l’expérience de terrain, les normes locales ou les contraintes matérielles pour valider ou rectifier les recommandations algorithmiques.

L’essor des modèles de langage et des agents autonomes amène à déplacer une part substantielle du travail analytique vers des processus automatisés ; toutefois, il met aussi en évidence les limites persistantes de l’intelligence computationnelle lorsqu’il s’agit d’interpréter une situation ouverte, de gérer des relations sociales ou de décider dans l’incertitude. La littérature consacrée à la collaboration humain-IA emploie le terme co-agency pour décrire l’articulation de deux systèmes cognitifs aux propriétés différentes : la machine excelle dans le calcul à grande échelle, l’humain conserve une supériorité dans l’intégration contextuelle, l’évaluation normative et la création de sens . Les travaux issus de la psychologie organisationnelle montrent, par exemple, que la valeur d’un résultat hybride dépend moins de la capacité brute du modèle que de la faculté des acteurs humains à orienter la tâche, à reconnaître la pertinence d’une suggestion algorithmique et à décider de l’abandonner ou de la transformer lorsque les conditions évoluent .

La notion de capacité humaine distinctive renvoie ainsi à des compétences que l’IA ne réalise pas de manière autonome : donner sens à des signaux faibles, concevoir des cadres interprétatifs inédits, arbitrer entre des valeurs incompatibles, créer la confiance au sein d’un collectif. Dans les recherches sur le sense-making, Weick souligne que l’interprétation d’un environnement ambigu exige un aller-retour continu entre expérience vécue, connaissances tacites et récits partagés . Or la majorité des modèles génératifs opèrent hors de ce cycle incarné ; ils recombinent des régularités issues de corpus passés sans interaction directe avec le contexte immédiat. De même, la créativité conceptuelle — c’est-à-dire la capacité à établir des rapprochements inhabituels entre domaines éloignés ou à modifier les règles du problème — reste difficile à formaliser en apprentissage automatique, sauf sous formes de variations statistiquement plausibles.

La responsabilité morale offre un autre exemple de dissymétrie fonctionnelle. Lorsque des systèmes de recommandation clinique ou financière suggèrent un choix, les recherches en éthique appliquée rappellent que la légitimité finale repose sur un agent humain capable d’assumer les conséquences de la décision . Cette charge implique l’évaluation de dimensions qui ne sont pas entièrement capturées par les données : la vulnérabilité des personnes concernées, l’équité de la procédure ou la compatibilité avec des normes juridiques locales. Dans les milieux professionnels, la coexistence d’équipes mixtes — constituées de personnes et d’agents algorithmiques — fait apparaître un besoin croissant de compétences relationnelles : empathie, négociation, leadership distribué . Ces qualités soutiennent la confiance, essentielle pour exploiter efficacement les capacités de l’IA sans générer de dépendance ni de résistance.

Enfin, plusieurs études soulignent l’importance de l’orchestration métacognitive, définie comme la capacité à planifier, surveiller et ajuster la contribution respective de l’humain et de la machine tout au long d’un processus. Cette compétence inclut la reconnaissance des situations où l’assistance algorithmique apporte un bénéfice (vitesse, exhaustivité) mais aussi celles où elle risque d’introduire des biais ou de masquer des signaux contextuels importants. Elle suppose la construction de règles de passage : moments explicites où l’autorité décisionnelle revient de l’IA à l’opérateur humain, et inversement.

Placer ces capacités humaines distinctives au cœur de la formation répond donc à un double objectif. D’une part, il s’agit de garantir que l’automatisation ne dilue pas l’autonomie intellectuelle ni la responsabilité sociale ; d’autre part, il convient de doter les apprenants de ressources cognitives aptes à complémenter, plutôt qu’à répliquer, les forces de l’intelligence artificielle. La présente dimension encapsule ces exigences en identifiant les domaines où l’investissement pédagogique demeure indispensable pour maintenir une collaboration équilibrée et fiable entre humains et systèmes d’IA.

Liste des capacités humaines distinctives

- Sense-making holistique

- Détecter et relier des signaux faibles ou contradictoires pour construire des interprétations situées.

- Créativité conceptuelle

- Élaborer des cadres, métaphores ou hypothèses inédites afin d’orienter ou de dépasser les propositions de l’IA.

- Jugement moral et responsabilité

- Apprécier les implications éthiques, juridiques et sociales d’une décision assistée par IA et en assumer la charge.

- Empathie et leadership relationnel

- Maintenir la confiance, la motivation et l’alignement des parties prenantes dans des équipes où interviennent des agents algorithmiques.

- Synthèse interdisciplinaire

- Combiner des savoirs de domaines hétérogènes pour créer des solutions ou des analyses que l’IA n’aurait pas inférées.

- Orchestration métacognitive

- Planifier, surveiller et ajuster l’ampleur de l’intervention de l’IA tout au long d’un processus de travail.

- Connaissance incarnée et contextuelle

- Mobiliser l’expérience de terrain, les normes locales ou les contraintes matérielles pour valider ou rectifier les recommandations algorithmiques.

Conclusion

La cartographie quadridimensionnelle présentée – capacités de l’IA, compétences essentielles de vérification critique, littératie IA et capacités humaines distinctives – propose un cadre intégré pour analyser et développer la compétence dans un environnement où cognition et action sont réparties entre agents humains et systèmes algorithmiques. Chaque dimension répond à une fonction précise :

- Les capacités de l’IA décrivent un périmètre d’automatisation en constante évolution. Les caractériser permet de déterminer ce qui peut être délégué de façon sûre et efficiente, et de réorienter l’effort pédagogique vers la formulation d’objectifs, la supervision et l’interprétation.

- Les compétences essentielles fournissent le socle disciplinaire, méthodologique et normatif qui rend possible l’audit raisonné des productions génératives ; elles garantissent la fiabilité scientifique et la conformité réglementaire.

- La littératie IA constitue le lien opératoire : elle dote l’apprenant des gestes et connaissances techniques nécessaires pour configurer l’outil, évaluer ses sorties et réguler ses usages dans des situations authentiques.

- Les capacités humaines distinctives rappellent la part irréductible de la responsabilité, de la créativité conceptuelle et de l’empathie ; elles assurent l’ancrage social et éthique des décisions prises avec l’appui de l’IA.

En articulant ces quatre volets, le cadre éclaire deux enjeux majeurs. D’une part, il permet de distribuer explicitement les responsabilités : l’IA assure la rapidité et l’ampleur du traitement informationnel ; l’humain conserve la décision finale, le jugement moral et la mise en contexte. D’autre part, il offre une base opérationnelle pour la conception curriculaire : chaque dimension peut faire l’objet d’objectifs d’apprentissage, d’activités dédiées et d’évaluations adaptées, facilitant ainsi l’intégration progressive de l’IA dans les disciplines sans sacrifier les exigences académiques.

Le cadre ouvre également plusieurs pistes de recherche et de suivi :

- Mesurer l’efficacité de l’orchestration : développer des indicateurs permettant de relier la qualité de la collaboration humain-IA à la performance globale et à la fiabilité des productions.

- Observer l’évolution des frontières : documenter les déplacements réguliers du périmètre de l’automatisation afin d’ajuster en continu les compétences essentielles et la littératie requise.

- Évaluer l’impact éthique et sociétal : analyser comment les décisions prises dans une équipe hybride affectent l’équité, la transparence et la responsabilité au sein des organisations et des communautés.

Enfin, l’approche quadridimensionnelle rappelle que la formation n’a pas pour but de remplacer l’expertise humaine par la puissance de calcul, mais de cultiver la capacité à coordonner ces deux ressources de manière réflexive, responsable et durable. En dotant les apprenants de repères conceptuels solides, de techniques d’interaction maîtrisées et d’un sens aigu de la responsabilité, les institutions peuvent accompagner l’intégration de l’intelligence artificielle tout en protégeant l’autonomie intellectuelle et la finalité sociale de l’éducation.

Bibliographie

Anthropic. (2024). Claude 3 model family : Model card (v 1.0). Anthropic.

Bano, M., Pan, Z., & Papadimitriou, A. (2025). AI literacy and trust: A multi-method study of human–GAI team collaboration. International Journal of Human-Computer Studies, 199, 102086.

Dawson, S., Joksimovic, S., Mills, C., Gašević, D., & Siemens, G. (2023). Advancing theory in the age of artificial intelligence. British Journal of Educational Technology, 54(5), 1980-1993.

Dellermann, D., Ebel, P., Söllner, M., Bitzer, M., & Leimeister, J. M. (2019). Hybrid intelligence. Business & Information Systems Engineering, 61(5), 637-643.

EDUCAUSE. (2024). AI literacy in teaching and learning: Executive summary. EDUCAUSE.

European Union. (2024). Regulation (EU) 2024/1689 of the European Parliament and of the Council of 11 January 2024 laying down harmonised rules on artificial intelligence (AI Act). Official Journal of the European Union.

Hutchins, E. (1995). Cognition in the wild. MIT Press.

International Organization for Standardization. (2024). ISO/IEC 42001:2024 – Artificial intelligence management system requirements. ISO.

Jarrahi, M. H. (2018). Artificial intelligence and the future of work: Human–AI symbiosis in organizational decision making. Business Horizons, 61(4), 577-586.

Lee, D., & Palmer, E. (2025). Prompt engineering in higher education: A systematic review to inform curricula. International Journal of Educational Technology in Higher Education, 22(1), 7.

Li, Y., Du, Y., Zhou, K., Huang, J., & Shi, Y. (2023). Evaluating object hallucination in large vision–language models. In Proceedings of the 2023 Conference on Empirical Methods in Natural Language Processing (pp. 250-263).

Lyytinen, K., Hansen, S., Henfridsson, O., & Yoo, Y. (2024). Design principles for artificial-intelligence-augmented decision making. Journal of Strategic Information Systems, 33(1), 101743.

Markauskaite, L., & Goodyear, P. (2022). What capabilities do learners need for a world with AI ? Computers & Education: Artificial Intelligence, 3, 100056.

Mercier, H., & Sperber, D. (2011). Why do humans reason ? Arguments for an argumentative theory. Behavioral and Brain Sciences, 34(2), 57-74.

OpenAI. (2024). GPT-4o system card (v 1.0). OpenAI.

Pan, Z., Moore, O. A., & Papadimitriou, A. (2025). Contextual factors influencing AI literacy and trust. Computers & Education, 210, 104806.

Puranam, P. (2021). Human–AI collaborative decision making as an organization-design problem. Journal of Organization Design, 10(1), 17-27.

Shrestha, Y. R., Benner, M., & von Krogh, G. (2023). Human–AI collaborative decision making as an organization-design problem. MIS Quarterly Executive, 22(4), 275-289.

Siemens, G., Dawson, S., & Gašević, D. (2022). Human and artificial cognition: Rethinking learning at the intersection. Computers & Education: Artificial Intelligence, 3, 100107.

Topol, E. (2019). High-performance medicine: The convergence of human and artificial intelligence. Nature Medicine, 25, 44-56.

UNESCO. (2025). AI competency framework for students (2ᵉ éd.). UNESCO Publishing.

Weick, K. E. (1995). Sensemaking in organizations. Sage.