Ce robot humanoïde est un jouet avancé, dont on peut programmer les mouvements grâce à un smartphone.

© Peter Nicholls / Reuters

Siri, Aido, Roxxxy : intelligences augmentées ou automates, les robots se déclinent en tondeuse, conseiller, ami. Si ces engins surdoués n’ont pas encore dépassé la science-fiction, ils s’en approchent. Avant qu’ils n’imposent leur loi, n’est-il pas temps de leur donner un cadre juridique ? Sylvain Métille, spécialiste du droit de la protection des données et des nouvelles technologies, dit oui.

Qui blâmer si un gestionnaire de fortune algorithmique mène son client à la banqueroute ? Et si la tondeuse à gazon robot démolit le champ du voisin ou que le robot-chirurgien rate son opération ? Que se passera-t-il lorsque la Google Car – un véhicule sans chauffeur pour l’instant au stade expérimental – devra choisir entre sauver ses occupants ou un piéton en cas d’accident ? Comment envisager la venue des drones autonomes ? A ce jour en Suisse, les robots n’ont aucun statut juridique. Faut-il changer les lois aujourd’hui déjà ? L’avocat Sylvain Métille, docteur en Droit et chargé de cours à l’UNIL à la Faculté de droit, des sciences criminelles et d’administration publique, est convaincu que le moment est venu d’y penser. Entretien.

AS : Quelle est la définition du robot qui mérite un statut juridique ?

Sylvain Métille : Cela reste une question ouverte. On a besoin de faire un vrai choix de société. Soit on considère que, malgré toutes les évolutions, il s’agit d’un automate contrôlable et que tous les robots ne sont que des grille-pain améliorés qui suivent des règles : il n’y a alors aucune raison de développer de nouvelles lois, la responsabilité revenant au fabricant, au vendeur, voire à l’utilisateur. Soit on estime que le robot a une capacité d’intelligence augmentée (terme qui a succédé à artificielle) et on doit se demander dans quelle mesure il peut prendre des décisions sur la base d’instructions qu’on ne lui aurait pas données. Dans ce contexte-ci, il fait sens de créer une personnalité robot ou un système particulier pour le traiter.

Qu’entendez-vous exactement par «personnalité» robot ?

La version simple serait d’avoir, à la manière d’une personne morale, une entité juridique séparée qui inclurait une responsabilité limitée du robot en tant qu’objet et/ou système informatique. C’est-à-dire que les actes du robot lui seraient imputables et non plus au fabricant ou au propriétaire. Il s’agirait d’une personne au sens juridique, et non humain. Et pour équilibrer le fait qu’on dédouane le propriétaire ou le fabricant de ses responsabilités, on pourrait avoir une compensation en argent, sous forme d’assurance. De la même façon qu’on compense la dangerosité d’une voiture par l’obligation de contracter une assurance. Ou on peut établir un parallèle avec la personne morale dans laquelle la responsabilité du marchand n’est plus celle de la personne individuelle, mais le capital social de la société, qui assume la responsabilité en cas de défaut de paiement. Dans l’idée du machine learning, le robot arrive à apprendre, mais il apprend à partir de ce qu’on l’a entraîné à effectuer. Il n’est pas complètement autonome. Il pourrait ainsi y avoir responsabilité de celui qui le forme.

Quels engins sont comparables à une personne morale ?

Actuellement aucun, selon moi. Le robot aspirateur, tondeur, le démineur ou l’humanoïde Nao ne peuvent être assimilés à une personne morale. Même s’ils sont intelligents, montrent des émotions, ils restent des objets juridiquement. On pourrait leur créer un statut particulier qui s’inspirerait de celui de la personne morale. Mais ce n’en sera jamais une. A ce stade, on arrive encore à se débrouiller avec nos lois, car ils sont limités dans leurs capacités. Les robots médicaux par exemple restent des outils. Celui qui assiste la main du médecin lors d’une intervention n’est qu’un scalpel évolué. Aucun robot ne reçoit de patients en cabinet et juge seul de la pertinence d’une opération. Cependant, quand un tel robot existera, il faudra se poser la question de sa responsabilité.

Avocat, chargé de cours à l’UNIL à la Faculté de droit, des sciences criminelles et d’administration publique.

Nicole Chuard © UNIL

La Google Car conduit seule, elle. Où la situer dans la loi ?

Même si on admet qu’elle ne fait qu’obéir à des règles préétablies, comme un automate, la loi sur la circulation routière doit être modifiée, parce qu’un véhicule a l’obligation de posséder un chauffeur. De plus, la conduite sur route nécessite un permis, ce que la Google Car n’a pas. Ce qu’on demande à ce jour, c’est qu’un conducteur humain se trouve derrière le volant pour en tout temps pouvoir reprendre le contrôle. Il s’agit juste d’une assistance à la conduite, tel le régulateur de vitesse, sauf qu’elle est plus évoluée.

Des tests sont réalisés à Zurich sur un véhicule similaire.

Oui, les chercheurs ont reçu des autorisations temporaires limitées pour effectuer des tests où la voiture est censée être autonome. Mais l’humain reste derrière. Certains Etats américains sont allés plus loin et ont permis à une voiture de rouler seule, sans aucun conducteur dedans. Cela impliquera une modification de la loi, si la phase de test est convaincante. Certes, il y a eu des accidents. Mais quand il s’agit uniquement de la responsabilité du véhicule, cela pose moins de problèmes, car, pour le mettre en circulation, le propriétaire doit l’immatriculer et contracter une assurance. Tandis que pour posséder un robot qui marche et fait les courses pour moi au supermarché, le cadre juridique actuel ne prévoit rien. La transition d’un véhicule avec un conducteur à une voiture autonome sera plus aisée que celle d’un robot dans un monde où il n’est pas prévu. Toutefois, comme on va retirer la responsabilité humaine, on devra légiférer sur un système particulier de responsabilité du véhicule.

Et si, lors d’un accident, le véhicule doit choisir entre tuer ses passagers ou un piéton ?

Ce sera plus facile pour le robot que pour l’humain, car il effectue très vite un calcul de probabilités. Autre exemple: deux personnes marchent sur la route et il n’arrive pas à freiner. Qui écrase-t-il, l’enfant ou la personne âgée ? Probablement la personne âgée qui a une espérance de vie moins longue que l’enfant, pour autant que les conséquences sur la personne qu’il va écraser soient les mêmes. En effet, s’il roule moins vite et qu’il prend en compte la résistance de celui qui est heurté, cela peut pondérer le calcul. Est-il moins dommageable d’avoir un mort ou un blessé ? Apparemment, ce genre de cas peut s’intégrer à la mémoire des robots. La difficulté reste de savoir qui prend la responsabilité éthique et morale de tels actes. Est-ce pour le fabricant ou faut-il que cela soit écrit dans les règles de circulation routière ? Il est interdit de rouler à plus de 50 km/h dans les villages. Dans notre exemple, on pourrait aussi concevoir qu’on doit écraser la personne la plus âgée, plutôt que l’enfant.

Les concepteurs de la Google Car lui ont attribué une personnalité agressive. Au contraire de Philips dont l’aspirateur autonome se veut calme et poli. Un gag ?

Non, je ne vois pas cela comme des traits de caractère. On leur fournit simplement des règles de comportement humain à adopter. Les testeurs ont remarqué que si la Google Car roulait trop bien, d’un pur point de vue scientifique, elle n’était pas acceptée sur la route. Il fallait qu’elle ait un comportement agressif pour ressembler aux autres conducteurs. Tandis que si elle laissait la priorité, alors qu’elle l’avait, dans le but d’une meilleure fluidité du trafic par exemple, ça n’était pas compris par les usagers. Ainsi le véhicule choisit ce qui est le plus favorable pour lui (comme un humain), et non pour l’ensemble du trafic.

Une règle qui ne suit pas les lois d’Asimov, puisque le robot se favorise au détriment de l’humain.

Oui, mais s’il promène son humain et qu’il le fait passer avant les autres, Asimov reste valable. Cela pose toute une série de questions inimaginables auparavant. Telles que: qui sauve-t-on en premier ? Est-ce éthique, politiquement recevable, d’avoir un cadre de situation routière qui explique qui on écrase d’abord ? Mais c’est aussi totalement immoral, et inacceptable, de refuser de se poser la question, alors qu’on sait que cela va arriver.

Et comment légiférer sur les drones ?

Actuellement en Suisse, le drone est plus considéré comme un grille-pain que comme un robot, parce qu’il ne vole pas seul. Jusqu’à 30 kilos, il n’est soumis à aucune autorisation, mais doit se trouver à une distance visible de son propriétaire. Il n’a pas le droit de voler à moins de 100 m d’une foule ou 5 km d’un aéroport. Une assurance RC est nécessaire si le drone dépasse 500 g. Au-dessus de 30 kilos, les règles à suivre sont les mêmes que pour un avion. Donc, un cadre existe. Et dès cette année (2017), l’OFAC (Office fédéral de l’aviation civile) offre une procédure de certification aux fabricants. Le drone est appréhendé sous l’angle de l’objet volant qui risque de perturber le trafic, de tomber, d’occasionner des dégâts, voire de tuer quelqu’un. Ces risques existent indépendamment de savoir si le drone est autonome, a un pilote, ou pas.

Les robots militaires posent aussi problème…

La plupart d’entre eux restent des outils. On en fait des armes qui sont contrôlées par des humains. Comme les drones. D’ailleurs, au début, il existait surtout des drones militaires. Aux Etats-Unis, quand les drones civils sont apparus, on a préféré utiliser le terme de unmanned aircraft (engin sans pilote) pour éviter le parallèle avec l’armée. Et pour cause: des pilotes américains, basés dans le Nevada, pouvaient tuer à des milliers de kilomètres de là et sortaient ensuite de leur poste de commande pour retourner à la vie civile. Cela a profondément choqué. De plus, il y a le risque que la contre-attaque ne vise pas le drone, mais son poste de commandement sur sol américain. Dans un souci commercial, le nom a alors changé. Le robot létal autonome, lui, pose le problème de la responsabilité de celui qui l’a configuré pour éviter qu’il commette une erreur. Dans un contexte de guerre, il est néanmoins plus difficile de faire valoir ses droits en tant que victime. Cette question est surtout appréhendée du point de vue des droits de l’homme, de la transparence du fonctionnement et de la banalisation d’actes de guerre.

Certains soldats s’attachent à un robot démineur. Au point de lui donner un nom et de l’enterrer. Qu’en penser ?

A terme, cela pourrait peut-être devenir un problème de santé publique. Est-ce que l’attachement à une machine est un risque à évaluer et faut-il en protéger l’Homme malgré lui, comme pour les épidémies, les radiations, un contact avec des substances nocives ? Si le robot est de plus «déguisé» en humain, on peut y voir une tromperie. Vous n’allez pas accepter la caméra de surveillance de la police sous votre fenêtre. En revanche, vous ne vous méfiez pas de votre compagnon robot… Pourquoi ne pas imaginer une loi qui stipule que le robot ne doit pas trop se rapprocher de l’être humain pour sa santé mentale ? De la même façon qu’on limite la cigarette, l’alcool, les drogues. Pour compléter les lois d’Asimov, on pourrait ajouter, sous l’angle de la protection des données, l’obligation de transparence algorithmique de la part du fabricant, ainsi que de présenter un robot comme tel, de quoi il est fait, ses capacités, qu’on sache s’il s’agit d’un traitement automatique ou pas, où partent les données enregistrées. Il n’est ni un enfant ni un animal et ne peut avoir les mêmes droits. D’un point de vue global, cela paraît important de savoir si on croise quelqu’un dans la rue s’il est un robot ou si la personne qui m’appelle en est un. Il y a un intérêt public à définir un cadre juridique qui le considère comme dangereux, soumis à autorisation.

Pourquoi cela ne s’est pas encore fait ?

Parce que la question n’est pas encore assez actuelle et que cela n’est pas favorable à l’innovation. De l’autre côté, selon le principe de précaution, on ne sait pas vraiment ce qui va se passer avec le robot, donc on a envie d’interdire tout ce qui paraît incontrôlable, d’avoir un «bouton panique» on/off pour le neutraliser.

Le spécialiste de l’intelligence augmentée David Levy juge qu’en 2050, on épousera des robots. Vous y croyez ?

Je n’espère pas! Juridiquement, cela ressemblerait à l’achat d’une maison: s’engager durablement devant la société à gérer un objet. Le côté bilatéral des droits et obligations n’existe pas. La maison ne peut rien attendre de moi. Le souci, c’est de mettre des obligations à charge de l’humain dont en réalité personne ne bénéficie, si la machine est toujours considérée comme telle. On tomberait alors dans un cas d’aliénation que le droit ne peut permettre. Par contre, si on estime que l’ «emo-robot» (qui «a» des émotions) a une vraie personnalité, il doit avoir les mêmes droits que nous. Un scénario inquiétant. De la même manière qu’on a des lois sur la recherche génétique qui limitent les actions pour éviter d’avoir des bébés de recherche ou pourvoyeurs d’organes de remplacement, etc., peut-être devrait-on aussi légiférer maintenant sur ce qui est acceptable ou pas pour le développement des robots.

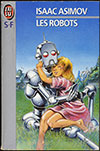

Les trois lois d’Asimov

La plupart des essais de lois sur les robots se basent sur une nouvelle de science-fiction, celle de l’écrivain américain Isaac Asimov, intitulée Cycle fermé, parue en 1942 dans le magazine Astounding Science Fiction. L’auteur y présente ses «trois lois de la robotique» :

Loi N° 1 Un robot ne peut porter atteinte à un être humain ni, restant passif, permettre qu’un être humain soit exposé au danger ;

Loi n° 2 Un robot doit obéir aux ordres que lui donne un être humain, sauf si de tels ordres entrent en conflit avec la première loi ;

Loi n° 3 Un robot doit protéger son existence tant que cette protection n’entre pas en conflit avec la première ou la seconde loi.

Au fil des années d’écriture, Asimov les a quelque peu affinées, mais elles restent le pilier des principaux projets de juridiction actuels et sont communément appelées «les trois lois d’Asimov».

Des pistes à suivre

• La Corée du Sud pionnière

Depuis 2007, les Autorités sud-coréennes planchent sur une charte de l’éthique des robots, fondée sur les trois lois d’Asimov. Le Conseil national des sciences et technologies de la communication, désireux de faire de la Corée le leader mondial de la robotique, pousse au développement d’humanoïdes cognitifs autonomes. Et a donc intérêt à légiférer avant la déferlante.

• Une motion européenne

En 2016, une motion a été déposée au Parlement européen «concernant des règles de droit civil de la robotique». En résumé, le rapport Delvaux estime qu’il faut que les employeurs qui remplacent un humain par un robot paient un impôt spécial (retenu sur les économies réalisées par ledit remplacement) pour les actuelles cotisations sociales, que les fabricants d’engins autonomes doivent avoir une assurance responsabilité civile et qu’un revenu universel de base doit être instauré (pour ne pas prétériter les êtres humains).

• Un avocat high-tech

Alain Bensoussan, avocat technologue au Barreau de Paris, fondateur de l’Association du droit des robots (ADDR), a imaginé 10 articles dans une «Charte des droits des robots». Il propose entre autres une définition: «une machine dotée d’intelligence artificielle, prenant des décisions autonomes, pouvant se déplacer de manière autonome dans des environnements publics ou privés et agissant en concertation avec les personnes humaines». Et établit ce qu’est la personne robot: elle «dispose d’un nom, d’un numéro d’identification, d’un capital et d’un représentant légal pouvant être une personne morale ou une personne physique».

Sources: www.alain-bensoussan.com | www.europarl.europa.eu